Tecnologia

Aprendizaje automático

Escena de la historia de las matemáticas

Música 01

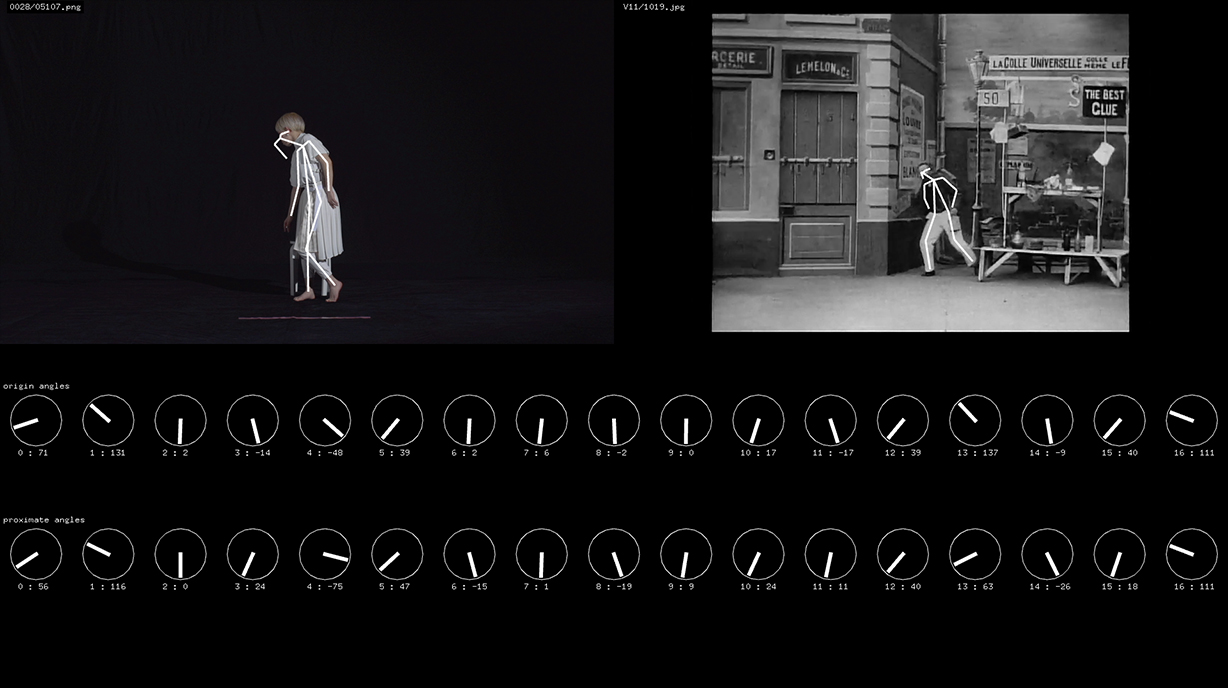

Usando OpenPose, analizamos distintas poses de imágenes teatrales y escenas de películas libres de derechos con tal de recopilar sus datos. Paralelamente, también analizamos la coreografía de las bailarinas. Luego usamos los datos recopilados sobre ambos tipos de poses para desarrollar un sistema de búsqueda de similitud (vecindad) entre ellas. A partir del vídeo de la coreografía, asignamos a cada fotograma la imagen con la pose que más se le parecía para crear un nuevo vídeo, con el que intentamos llevar a cabo la representación.

1 Escena de la audiencia

Música 09

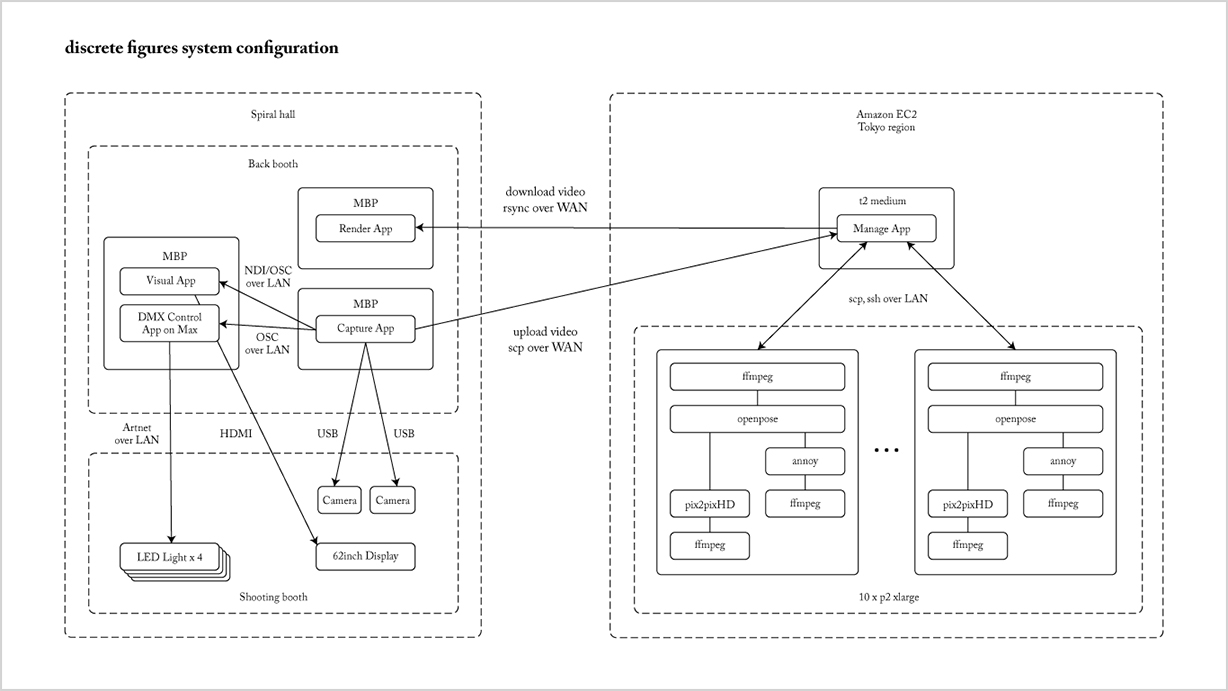

Instalamos un espacio en el vestíbulo del teatro en el que grabamos a los espectadores que habían acudido a ver el espectáculo. Hasta justo antes del inicio de la representación, usamos varios servidores remotos para analizar las características de los movimientos y la ropa de los espectadores grabados. Posteriormente, usando los datos obtenidos junto a los datos de los movimientos de las bailarinas de ELEVENPLAY, tratamos de conseguir que los espectadores aparecieran proyectados bailando sobre el escenario

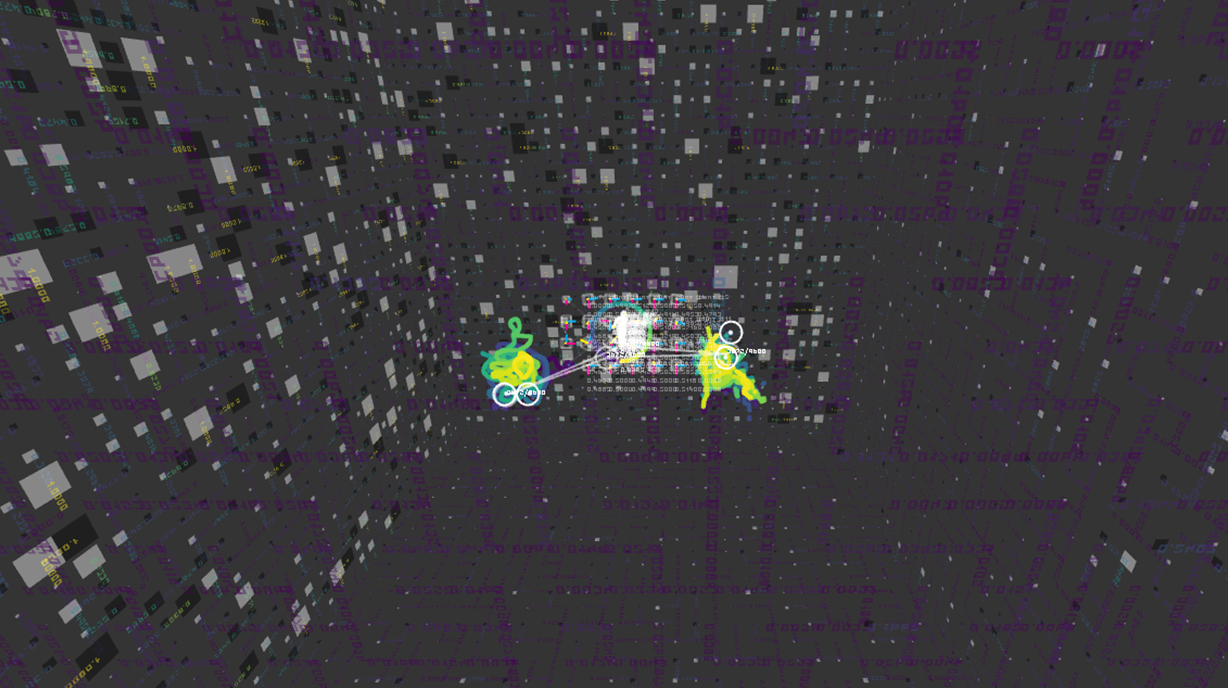

2 Escena de la reducción de la dimensionalidad

Música 09

Utilizando una técnica de reducción de las dimensiones, transformamos los datos de movimiento en datos 2D y 3D de forma que se pudieran visualizar.

Escena con una bailarina de IA

Música 10

Sentíamos interés por el arte de la danza en sí, por ejemplo, cuáles son las diferencias entre distintos bailarines o entre géneros, o cómo influyen la música y el ritmo en el baile improvisado. Con tal de investigarlo, desarrollamos junto a Parag Mital la red “dance2dance”:

https://github.com/pkmital/dance2dance

Esta red se basa en la arquitectura del “seq2seq” de Google. Como es una arquitectura de red neuronal artificial que se puede utilizar para el modelado secuencial, en este sentido se parece a “char-rnn”.https://google.github.io/seq2seq/https://github.com/karpathy/char-rnn

Para los datos del baile usamos un sistema de captura de movimiento, llevando a cabo capturas 40 veces aproximadamente, a 60 fotogramas por segundo, con lo que conseguimos un total de 2 horas y media de datos. En cada sección, las bailarinas improvisaron en base a 11 temas: alegría, enfado, tristeza, diversión, robótico, sexy, junkie, relajado, animado, ondeante y swing. Con tal de mantener un tiempo definido, se indicó a las bailarinas un ritmo de 120 pulsaciones por minuto.

Hardware

Drones

Usamos cinco microdrones del tamaño de la palma de la mano. Gracias a sus dimensiones reducidas presentan una mayor seguridad y maniobrabilidad comparadas con los drones normales. Asimismo, al ser máquinas muy pequeñas producen el efecto visual de que hay esferas de luz flotando en el escenario. A través de un sistema de captura de movimiento, se calcula su posición desde fuera del escenario, y se utiliza una señal inalámbrica en la franja de 2.4 GHz para controlarlos a tiempo real. El movimiento de los drones se genera en base al análisis previo de los datos tomados mediante captura de movimiento de las bailarinas.

Estructuras

Son un elemento clave que posibilita la utilización de realidad aumentada y a la vez actúa como pantalla semitransparente para el projection mapping. Las estructuras tienen siete LEDs infrarrojos, llevan incorporada una batería y son identificadas por el sistema de captura de movimiento como un cuerpo rígido. Los marcadores retro-reactivos normales se pueden ver a simple vista, por lo que no son del todo adecuados para su uso como atrezzo en un espectáculo. Por este motivo diseñamos y construimos por nuestra cuenta estas estructuras con el sistema de LED de luz infrarroja y planchas de reflexión difusa, de modo que los marcadores no se ven pero pueden ser seguidos de un modo fiable.