Abstract

ライゾマティクスは、Dentsu Lab Tokyoと共同開発でAR技術を用いてフェンシングの剣先の軌跡を可視化する、「Fencing Visualized Project」の基幹技術「Fencing tracking and visualization system」を開発している。2012年から様々な開発プロセスを経て、現在深層学習を用いることで、マーカレスで剣先を可視化出来る新システムへとアップデートさせた。人間の視覚では追いきれない剣先を検出、リアルタイムでAR合成し即時に軌跡のビジュアライズを行なっている。

本ウェブサイトでは、2012年から現在に至るまでの開発プロセスを紹介する。

Background

世界で最も歴史の古いスポーツのひとつフェンシング。世界での知名度も非常に高い反面、ほとんどの人がルールを知らず、競技を観戦していても何が起こっているのか理解が難しいスポーツである。

プロジェクトのバックグラウンド

2013年、日本人初のオリンピックメダリスト太田雄貴選手と電通が、これからのスポーツ観戦をテクノロジーの力でアップデートするための研究開発プロジェクトを企画していた。 フェンシングをよりわかりやすく、魅力的に見せることが出来ないかというお題のなか、ライゾマティクスが剣先を可視化するアイディアを提案、そしてプロトタイプの実装を担い、「Fencing Visualized Project」がスタートする。

ライゾマティクスのバックグラウンド

2012年当時、ライゾマティクスでは真鍋大度と石橋素がモーションキャプチャーやハイスピードカメラと自作のマーカー、ソフトウェアを用いてパフォーマーの速い動きをトラッキングし可視化するARのプロジェクトを行っていた。このプロジェクトは、主にダンサーの動きをトラッキングして動きにグラフィックを合成する試みである。

そんな中、フェンシング x テクノロジーのお題を与えられ、既に実プロジェクトでも使用し知見のあるシステムを展開することを考えた。

フェンシングの剣先は肉眼で捉えるのことは難しいが、剣先に小さなマーカーをつけることでハイスピードカメラでは捉えることが出来るのではと考え、まずフィジビリティのスタディを行った。

スタディの結果、マーカーを付ければ2012年時点の技術でも剣先がトラッキング出来ることを確認した上で、AR技術を用いて剣先の軌跡を可視化した映像を作成し、東京2020オリンピック・パラリンピック招致の際に紹介された。

また、東京2020オリンピックが開催されるまでに機械学習技術、画像解析技術が発達し、剣先にマーカーを付けず試合でも利用できる可能性が高いと判断し、AR技術を用いて剣先の軌跡を可視化する基幹技術「Fencing tracking and visualization system」を企画提案し、研究開発がスタートした。

フェンシングは現在、リアルタイムで検出される軌跡によって、試合の動向を誰でも理解し、楽しめるスポーツへと進化している。

System

2013年当初は、剣先に再帰性反射マーカーを付けて、光学式モーションキャプチャーシステムで剣先の軌跡を取得。その軌跡に対してARで映像効果を加え、よりわかりやすくフェンシングの魅力を伝えることを目的としポストプロダクションでの映像制作を行った。

2014年の太田雄貴杯では剣先にマーカーを付けて、デモマッチにおいて観客の前で初めてリアルタイムARのビジュアライズを披露した。2017年のNTTドコモ FUTURE EXPERIMENT Vol.2では、球型の反射マーカーを反射テープに変え、極力試合に影響が出ないように配慮してリアルタイムARのライブストリーミングを実施。

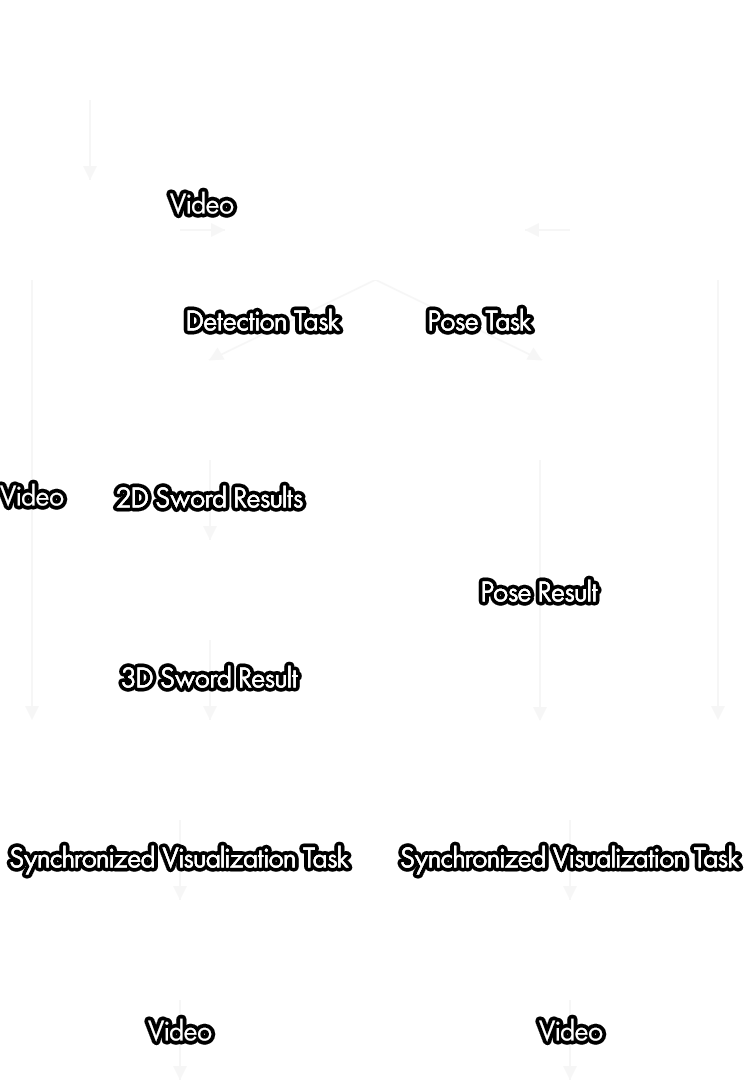

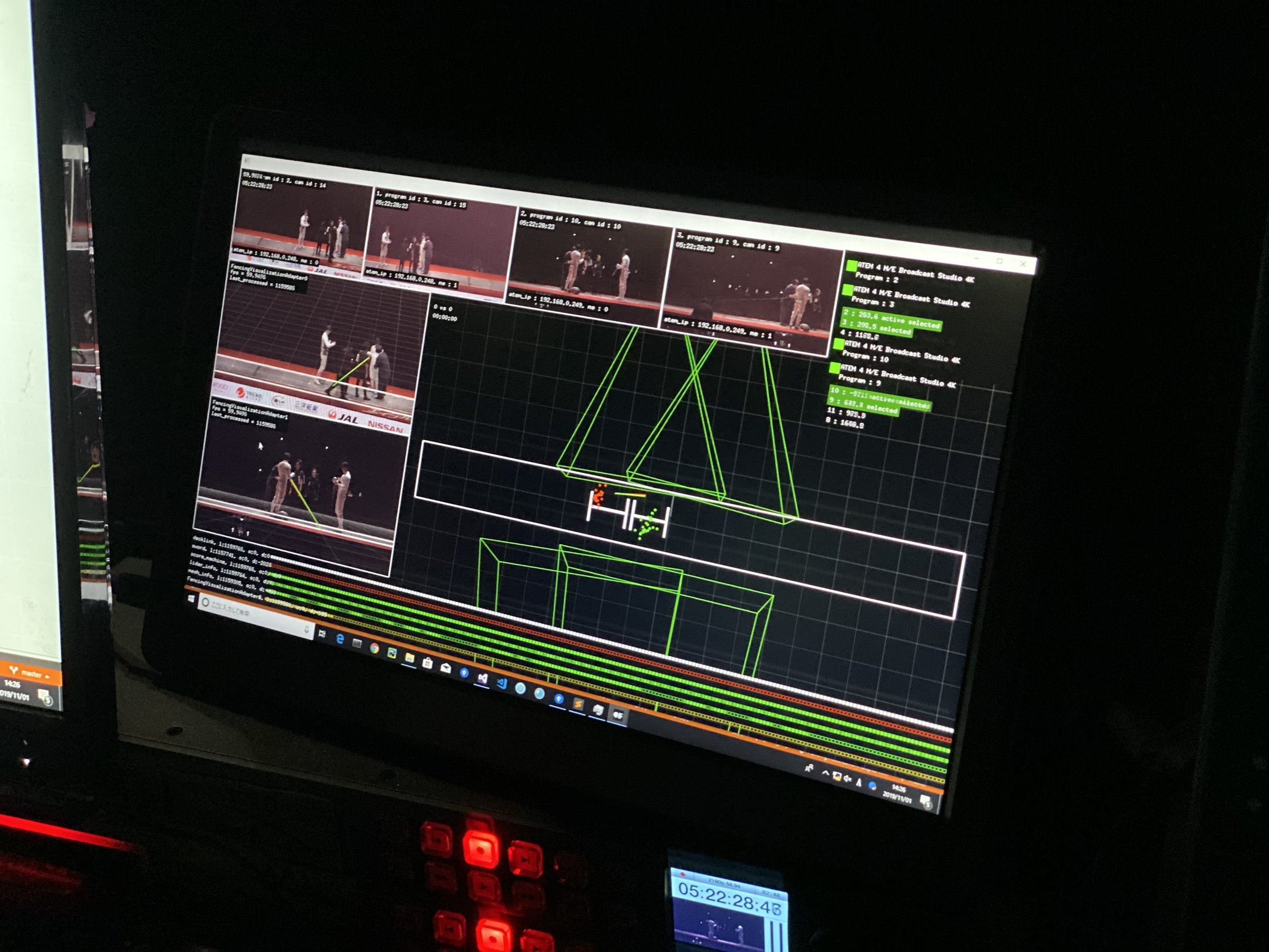

また2016年より、実試合導入を目標として、剣に一切の加工をせず、選手に負担をかけずに剣先の位置をカメラ画像のみから検出するためのシステムの開発を開始した。フェンシングの剣先は非常に早く動き、剣は曲がりやすいので形状変化が大きい。また剣先は4Kカメラで捉えて数ピクセル程度の幅しかなく、画像認識で見つけるには細すぎるといった問題があった。そのため、解析用カメラのハード選定からはじめ、一般物体認識用の深層学習アルゴリズムであるYOLO v3をベースに、多段構成の一般物体認識用の深層学習ネットワークを新規開発。4Kの解像度情報を失うことなく剣先位置を高精度に検出するアルゴリズムを開発した。また、1台のカメラでカバーできる範囲は8mほどしかないため、最終的にはピストの両サイドから24台の4Kカメラを設置し、試合領域全域をカバーすると同時に、剣先検出のロバスト性を向上させた。また、複数台の検出結果から3Dの剣先位置を推定するシステムの開発も行った。

本システムは2018年のエイブルPresents 第71回 全日本フェンシング選手権大会でエキシビションマッチで2Dによるデモンストレーションを披露し、2019年のエイブルPresents 第72回 全日本フェンシング選手権大会で実際の試合で初めて導入を行った。また、この実試合導入においては剣先の位置だけでなく、剣先の角度、剣のガード部分の位置と角度も検出できるようにした。これにより剣の正確な形状を取得することができるようになり、AR表現が2Dから3Dに進化し、前述の姿勢推定技術を組み合わせることでビジュアライズ表現も大幅にアップデートした。

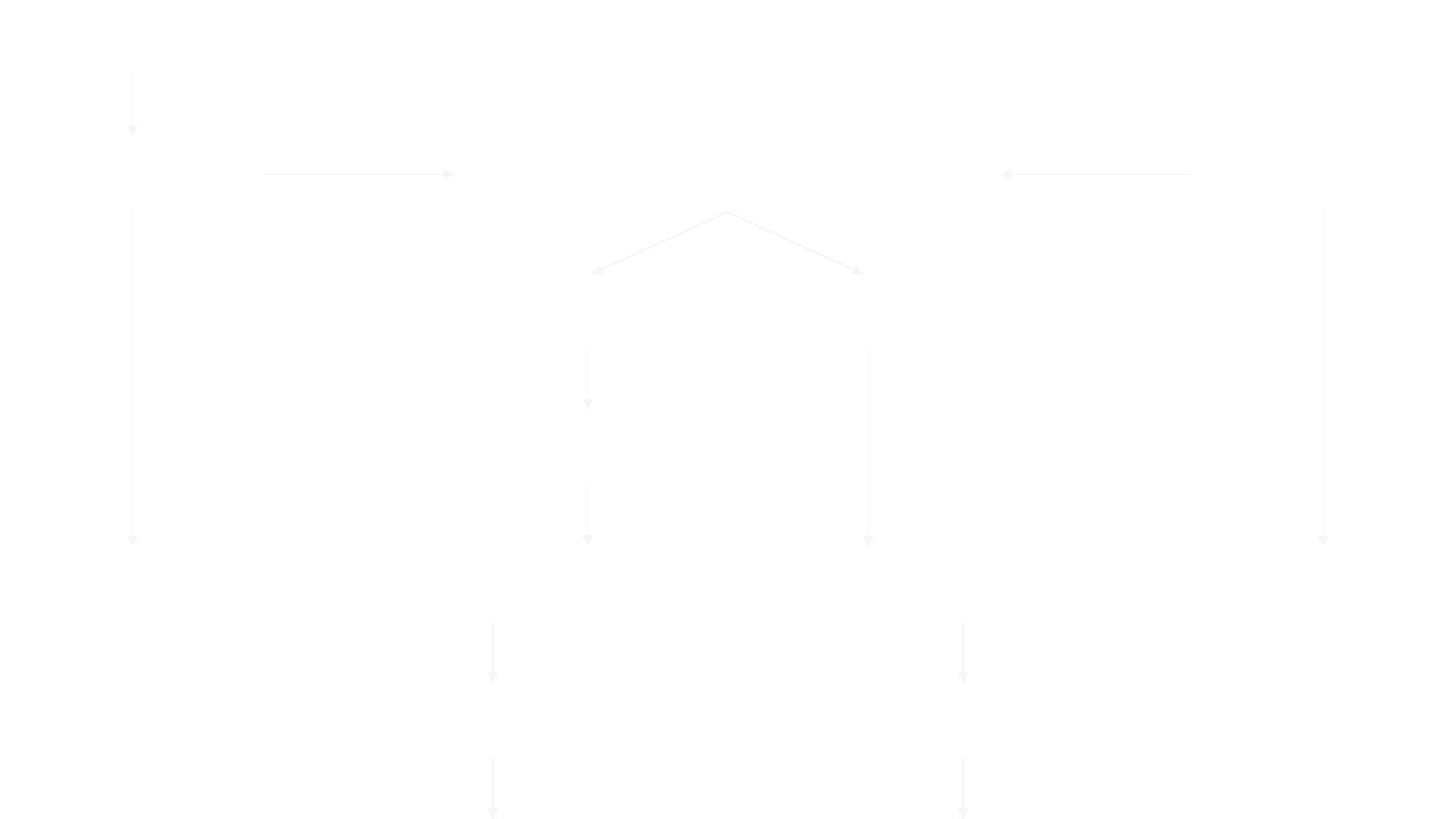

2019年JAL Presents 高円宮杯 World Cupにおけるシステム構成図

2D剣先検出アルゴリズムの概念図 (2018年時)

YOLO v3を2段階で適用することで高精度に剣先位置を復元。2019年以降、剣のガードも同様に検出するシステムにアップデートした。

Making

2014

再帰性反射マーカー付きの剣をリアルタイムにトラッキングし、ARで軌跡を合成するテスト

2016

マーカーレス剣先トラッキングの検証を開始。当時は単純なCVアルゴリズム(局所特徴量によるコーナー検出)での解決を試みたが、精度が出せず失敗。

2017

模擬試合の映像を撮影し教師データセットを作成して、機械学習でのアプローチを開始。深層学習の一般物体認識アルゴリズムYOLO v2での多段カスケードによる剣先検出に活路を見出すが、この段階では軌跡合成に必要な精度はでていない。

2018

一般物体認識アルゴリズムYOLO v3に移行し、トラッキングエリアをピスト中央に限定し、カメラ1台の構成で2Dでの剣先検出に成功。全日本選手権のエキシビションマッチでデモを披露。単純な動きの場合の軌跡生成は可能な精度だが、まだ実試合に耐えられる精度は出ていない。

2019

実試合導入及び高精度化に向けて、大規模な機械学習用データセットを新規撮影。キラメッセぬまづにて、8台のカメラ、12人の選手、

複数の背景照明条件で撮影。20万枚以上の画像にアノテーション。

合わせて、データオーグメンテーションを進めるために100万枚以上のCGのデータセットも作成した。これは、背景・剣の見た目・照明条件などを変えながらレンダリングしたCG画像を学習データセットとして使用できるようにしたものである。

3D推定アルゴリズム及び、リアルタイムシステム開発のためのミニチュア検証セットをスタジオに組み、画像情報のみから剣先位置のリアルタイム3D推定に成功。

エイブルPresents 第72回 全日本フェンシング選手権大会(2019)

JAL Presents 高円宮杯 World Cup

より高精度でトラッキングエリアを限定しないアルゴリズム及びシステムを開発。剣先の位置推定が2Dから3Dに進化し、フェンシングに特化した様々な拘束条件を導入することで剣先検出の精度及びロバスト性も実試合に耐えられるレベルに向上した。さらに、3D姿勢推定アルゴリズムをシステムに統合。それに伴いビジュアライズの表現も大幅にアップデートした。

Reference

- [1] Redmon, Joseph and Ali Farhadi. “YOLOv3: An Incremental Improvement.” ArXiv abs/1804.02767 (2018)

- [2] Redmon, Joseph and Ali Farhadi. “YOLO9000: Better, Faster, Stronger.” 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR) (2016): 6517-6525.

Credit

Fencing Visualized Project

- Creative Direction

- Kaoru Sugano (Dentsu Lab Tokyo)

- Planning, Creative Direction

- Daito Manabe

- Planning, Technical Direction, Hardware Engineering

- Motoi Ishibashi

- Technical Direction, System Development, Software Engineering

- Yuya Hanai

- Planning

- Kazuyoshi Ochi / Ryosuke Sone (Dentsu Lab Tokyo)

- Produce

- Kohei Ai (Dentsu Lab Tokyo)

Yuki Ota Fencing Visualized project -Technology×Fencing (2013)

- Technical Director

- Daito Manabe

- Technical Support

- Motoi Ishibashi, Yuya Hanai

*Fencing tracking and visualization system by Rhizomatiks Research (Daito Manabe + Motoi Ishibashi)

Yuki Ota Fencing Visualized project –Yuki Ota Fencing Championship (2014)

- Creative Director

- Daito Manabe

- Technical Director

- Motoi Ishibashi

- Programmer

- Yuya Hanai

- Technical Support

- Momoko Nishimoto, Toshitaka Mochizuki, Masaaki Ito

NTTドコモ | FUTURE-EXPERIMENT VOL.02 視点を拡張せよ (2017)

*Fencing tracking and visualization system

- Planning Creative Director

- Daito Manabe

- Technical Director Programmer

- Motoi Ishibashi

- System Engineer

- Yuya Hanai

- System Developer

- Ryohei Komiyama

- Visual Programmer

- Satoshi Horii

- System Operator

- Muryo Homma, Tai Hideaki

- System Operator Craft

- Toshitaka Mochizuki, Saki Ishikawa

- Project Manager, Producer

- Takao Inoue

エイブルPresents 第71回 全日本フェンシング選手権大会 (2018)

- Technical Direction, System Development, Software Engineering

- Yuya Hanai

- Planning, Creative Direction

- Daito Manabe

- Planning, Technical Direction, Hardware Engineering

- Motoi Ishibashi

- Visual Programming

- Satoshi Horii

- Visual Programming

- Futa Kera

- Videographer

- Muryo Homma

- Hardware Engineering

- Yuta Asai

- Hardware Engineering

- Kyohei Mouri

- Technical Support

- Saki Ishikawa

- Project Management

- Kahori Takemura

- Project Management, Produce

- Takao Inoue

エイブルPresents第72回全日本フェンシング選手権大会 (2019)

- Technical Direction, System Development, Software Engineering

- Yuya Hanai

- Planning, Creative Direction

- Daito Manabe

- Planning, Technical Direction, Hardware Engineering

- Motoi Ishibashi

- Software Engineering

- Kyle McDonald (IYOIYO)

- Software Engineering

- anno lab (Kisaku Tanaka, Sadam Fujioka, Nariaki Iwatani, Fumiya Funatsu), Kye Shimizu

- Dataset System Engineering

- Tatsuya Ishii

- Dataset System Engineering

- ZIKU Technologies, Inc. (Yoshihisa Hashimoto, Hideyuki Kasuga, Seiji Nanase, Daisetsu Ido)

- Dataset System Engineering

- Ignis Imageworks Corp. (Tetsuya Kobayashi, Katsunori Kiuchi, Kanako Saito, Hayato Abe,Ryosuke Akazawa, Yuya Nagura, Shigeru Ohata, Ayano Takimoto, Kanami Kawamura,Yoko Konno)

- Visual Programming

- Satoshi Horii, Futa Kera

- Videographer

- Muryo Homma

- Hardware Engineering

- Yuta Asai, Kyohei Mouri

- Project Management

- Kahori Takemura

- Project Management, Produce

- Takao Inoue

H.I.H. Prince Takamado Trophy JAL Presents Fencing World Cup 2019 (2019)

- Technical Direction, System Development, Software Engineering

- Yuya Hanai

- Planning, Creative Direction

- Daito Manabe

- Planning, Technical Direction, Hardware Engineering

- Motoi Ishibashi

- Software Engineering

- Kyle McDonald (IYOIYO)

- Software Engineering

- anno lab (Kisaku Tanaka, Sadam Fujioka, Nariaki Iwatani, Fumiya Funatsu), Kye Shimizu

- Dataset System Engineering

- Tatsuya Ishii

- Dataset System Engineering

- ZIKU Technologies, Inc. (Yoshihisa Hashimoto,Hideyuki Kasuga,Seiji Nanase,Daisetsu Ido)

- Dataset System Engineering

- Ignis Imageworks Corp. (Tetsuya Kobayashi, Katsunori Kiuchi, Kanako Saito, Hayato Abe, Ryosuke Akazawa, Yuya Nagura, Shigeru Ohata, Ayano Takimoto, Kanami Kawamura, Yoko Konno)

- Visual Programming

- Satoshi Horii, Futa Kera

- Videographer

- Muryo Homma

- Hardware Engineering&Videographer Support

- Toshitaka Mochizuki

- Hardware Engineering

- Yuta Asai, Kyohei Mouri, Saki Ishikawa

- Project Management

- Kahori Takemura

- Project Management, Produce

- Takao Inoue