Technology

Machine Learning

History Scene

Music 01

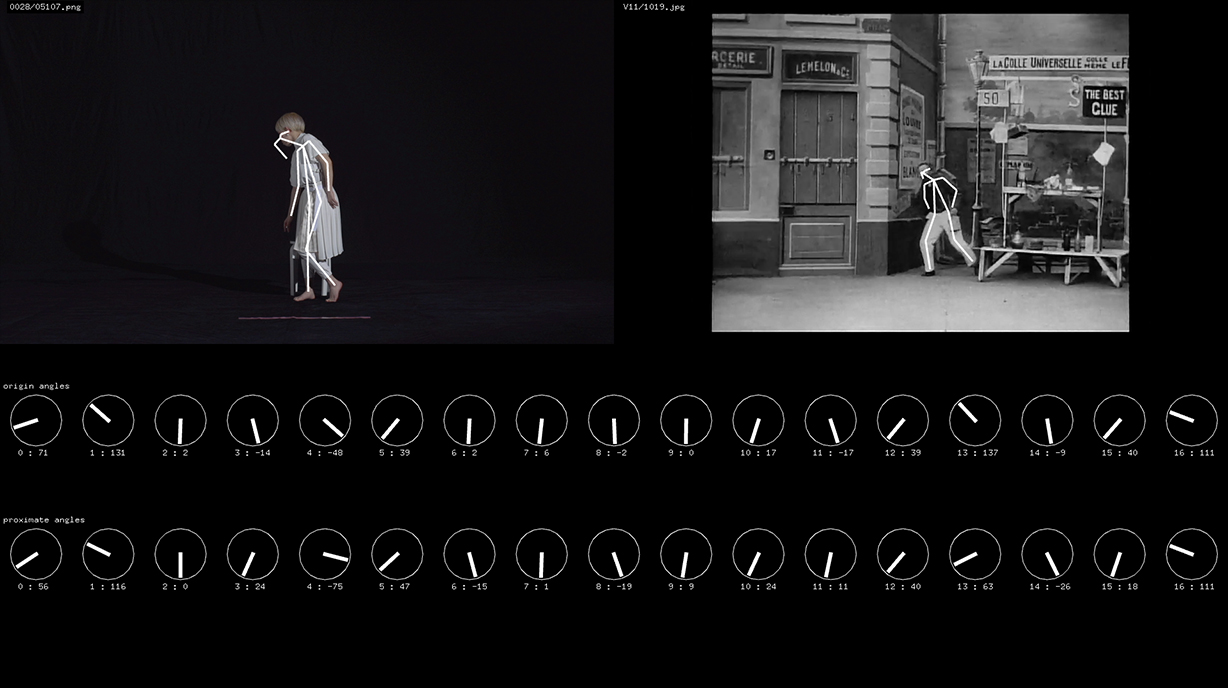

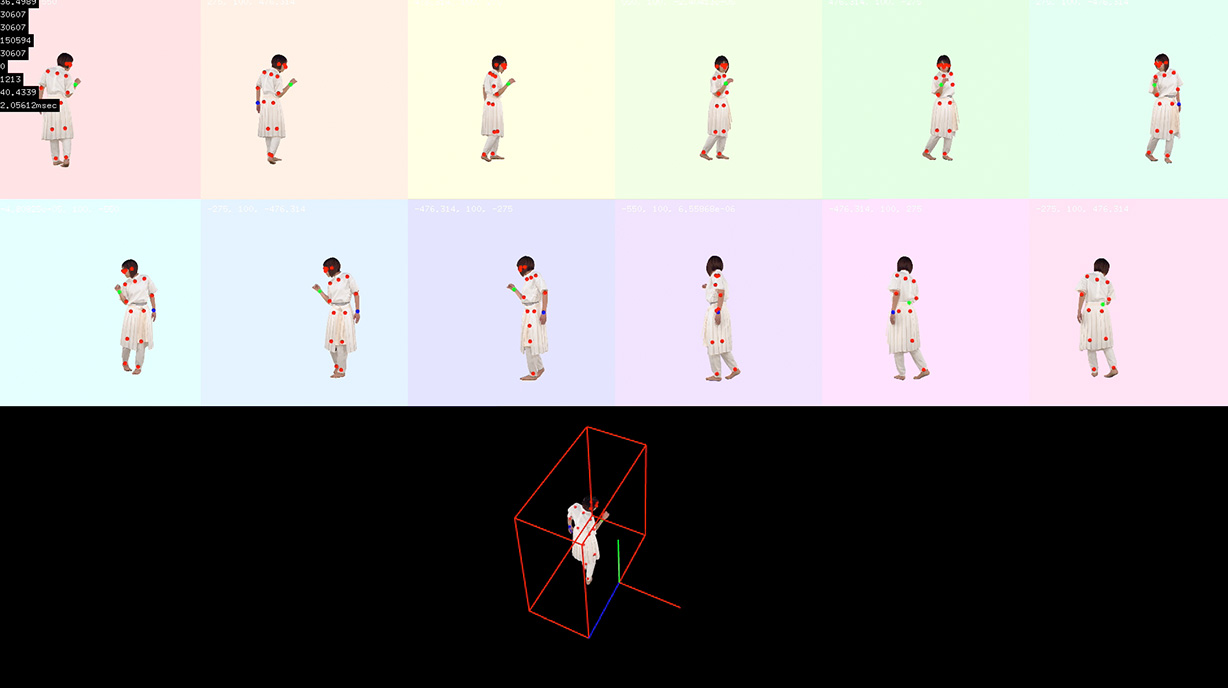

Openpose を用い、パブリックドメインの舞台映像、映画のシーンのポーズ解析をし、ポーズデータをデータ収集し、そのデータとダンサーの踊りを解析して取得したポーズデータとの近傍探索システムを開発。実際の振り付け動画から、フレーム単位で最も近しいとされたポーズを持つ映像素材を用いた演出を試みた。

1 audience scene

Music 09

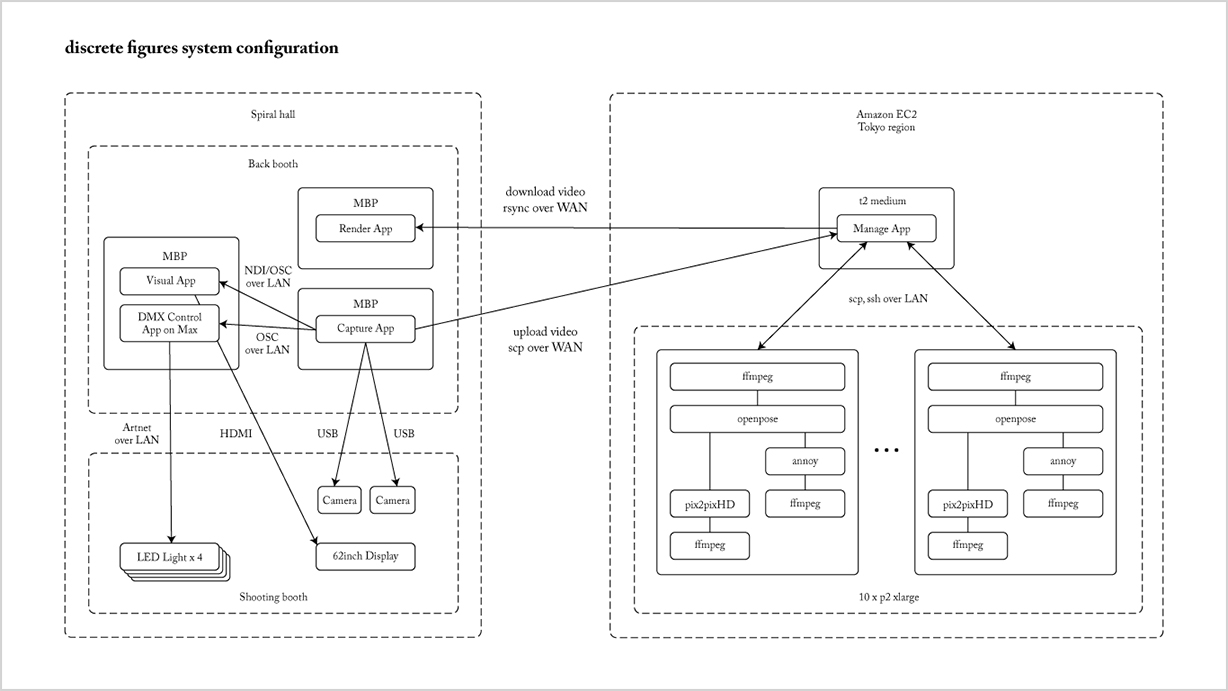

会場ロビーにブースを設置し来場者を撮影。

公演開始直前まで撮影データを複数のリモートサーバ上で体験者の服装の特徴や動きを解析し、その解析データとイレブンプレイのモーションデータを用いて観客がダンサーとしてスクリーンに登場する試みを行なった。

2 dimentionality reduction scene

Music 09

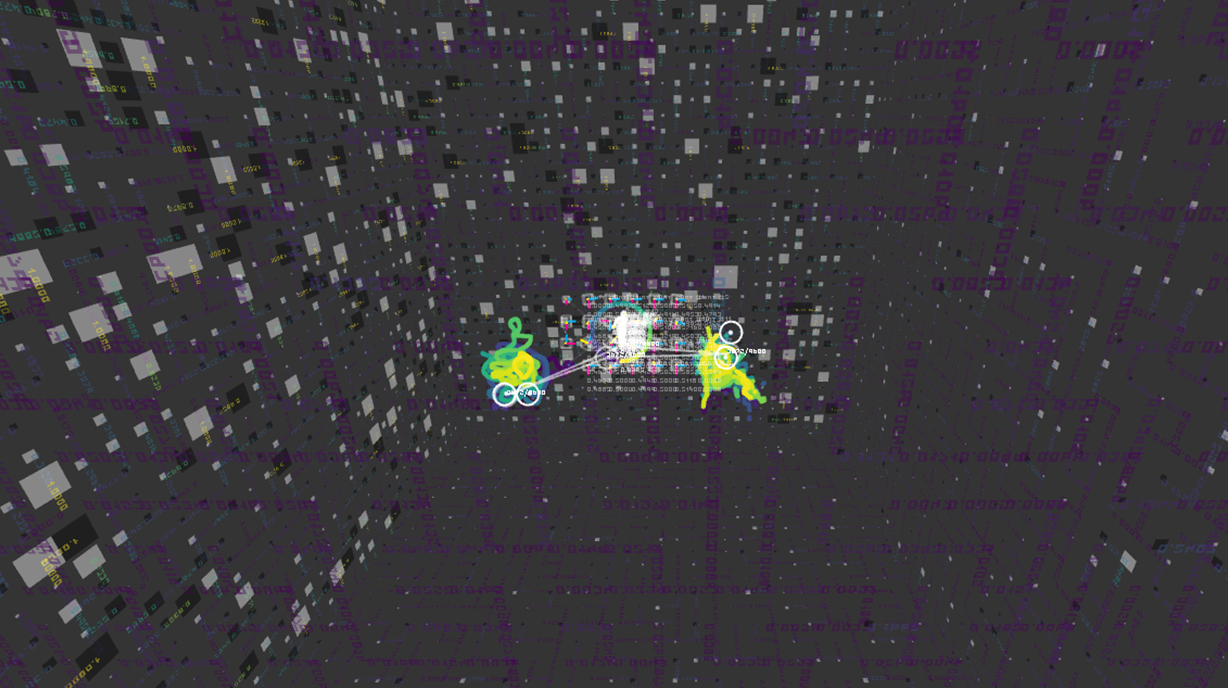

次元削減のテクニックを使用してモーションデータを2次元、3次元のデータに変換し、ビジュアライズを行なった。

AI Dancer scene

Music 10

私たちは、ダンサーとスタイルの違いや、音楽のリズムが即興のダンスとどのようにつながっているかなど、ダンスそのものに興味を持ち、探求のために、Parag Mitalと協力してdance2danceというネットワークを制作した。

https://github.com/pkmital/dance2dance

このネットワークは、Googleのseq2seqアーキテクチャに基づいています。これは、順次モデリングに使用できるニューラルネットワークアーキテクチャであるという点でchar-rnnに類似している。https://google.github.io/seq2seq/https://github.com/karpathy/char-rnn

ダンスのデータはモーションキャプチャシステムを使用して、約40回のキャプチャーを行い、60fpsで合計で約2.5時間のデータを収集した。 各セッションは、

joy, angry, sad, fun, robot, sexy, junkie, chilling, bouncy, wavy, swingy

という11つのテーマのもとでダンサーが即興で踊った。ダンサーは、一定のタイミングを保つため120bpmのビートを与えられた。

Background movie

今回、NVIDIA Researchの論文 “A Style-Based Generator Architecture for Generative Adversarial Networks” にて紹介された “StyleGAN” を背景映像を制作するのに活用した。

http://stylegan.xyz/paper

“StyleGAN” はオープンソース化されており、コードはGitHubにて入手可能である。

https://github.com/NVlabs/stylegan

今回、過去に取得したダンスパフォーマンスのデータを用い、この ”StyleGAN” をNVIDIA DGX Station上でトレーニングしている。

https://www.nvidia.com/ja-jp/data-center/dgx-station/

Hardware

Drone

手のひらサイズのマイクロドローンを5台使用。小型のため従来のものに比べて安全性と機動性が高い。また、機体が小さいため、ステージ上では光の玉だけが浮遊しているかのような視覚的効果がある。モーションキャプチャシステムにより外部より位置を計測し、2.4GHz帯の無線通信によりドローンをリアルタイム制御している。ドローンの動きはダンサーのモーションキャプチャーデータを事前に解析し生成している。

Frame

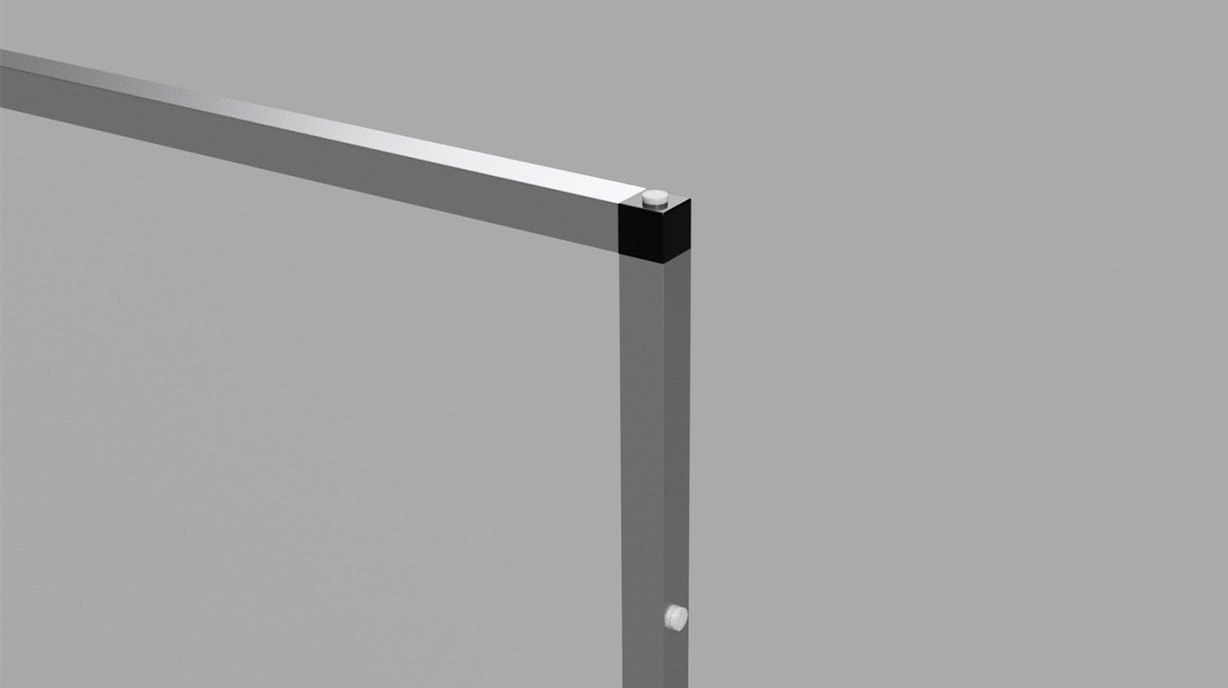

AR合成やハーフスクリーンへのプロジェクションマッピングにおいて重要な役割を果たす。フレームに7つの赤外線LED、バッテリーを内蔵し、全体を剛体としてモーションキャプチャシステムで認識している。通常の再帰性反射マーカーは肉眼でも見えてしまうためステージ小道具に利用するのはあまり適していないが、赤外線LEDと拡散反射板によって肉眼では見えないが安定してトラッキングができる仕組みを独自に設計、開発した。

AR System

AR System Technical features

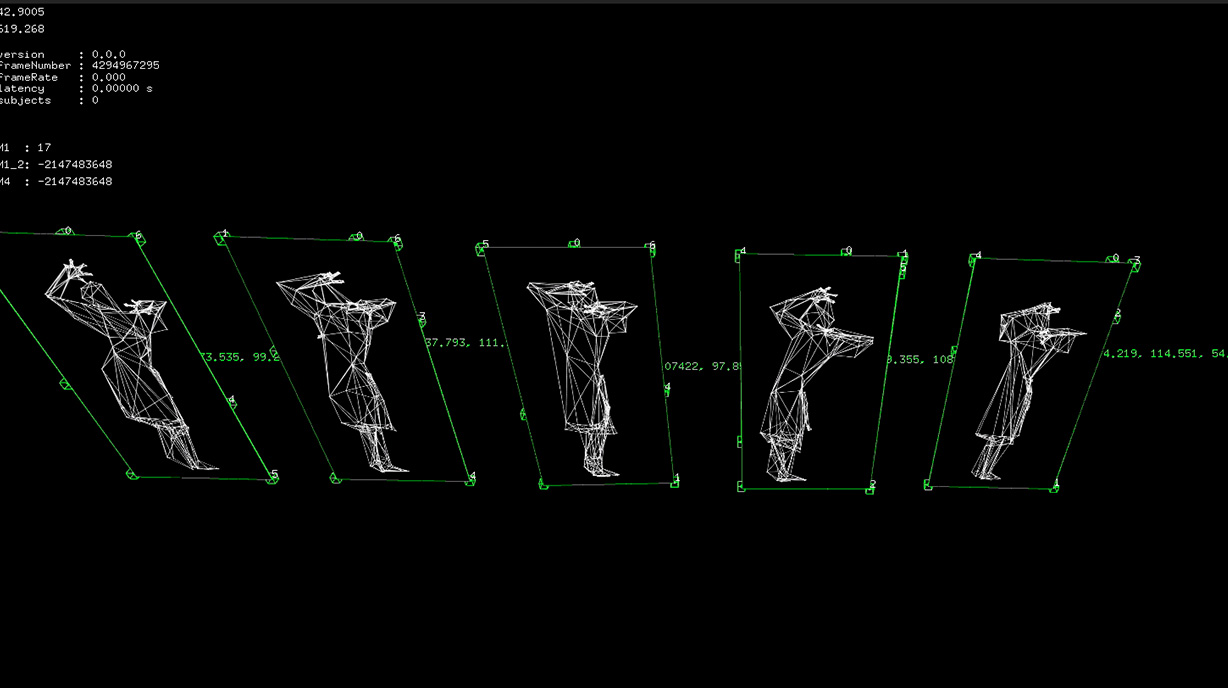

ARグラフィックスのリアルタイムレンダリングパイプラインにおいては、事前に4Dスキャン(時間軸も含む3Dスキャン)されたダンサーのハイクオリティなレンダリングシステムを新規開発。具体的には、まず事前に12視点からレンダリングしたダンサーの画像を生成し、機械学習アルゴリズムを使用し2D画像から骨格推定を行う。次に12視点分の2次元の疎な骨格情報から、3次元の骨格情報を再構成する。この仕組によって従来2パス(4Dスキャン+モーションキャプチャー)でしか得られなかった情報を1パス(4Dスキャンのみ)で得ることが可能になる。これは再現不可能な即興パフォーマンスであってもテクスチャとモーションを1パスのスキャンで取得可能なことを意味する。次にこの骨格情報を活用して4Dスキャンデータのテクスチャのマテリアル推定を行う。このマテリアル推定により衣装/肌/髪/目の自動分類を行いそれぞれ別のシェーディングを行うことで、4Dスキャンデータに対するレンダリングの高精細化を実現した。

Projection System Technical features

モーションキャプチャーシステムでトラッキング可能な動的オブジェクト(フレーム)に対してのダイナミックプロジェクションマッピング。独自開発のプロジェクターキャリブレーションシステムを使用し、フレームがステージのどこにあっても、フレームに対して正確に映像を投影することが可能。また映像出力の遅延を考慮し、位置の予測を行うことで、フレームが動いていてもズレのない投影が可能。また、モーションキャプチャーシステムでトラッキングしたフレームの位置情報だけでなく、フレームに取り付けられたマーカーの位置情報も併用することで、変換行列を自動推定し高精度な映像投影を実現した。

Projection/AR

短い開発期間でクオリティを最大限上げるために、「開発用データ」を先に取得し、本番同様の素材で開発できる状態を整えてからコンテンツの制作イテレーションを回していく、という仕組みを確立している。「開発用データ」というのはカメラ映像、モーションキャプチャーシステムのトラッキングデータ、センサーデータなど本番で取得可能なデータ一式のことである。今回はじめて、グラフィックスの描画を行いながら「開発用データ」をすべて取得できるシステムを開発した。これにより例えばARにおいてはゲネプロで取得したデータを使用してグラフィックスをブラッシュアップし、本番に反映させるような開発が可能になった。従来では合成後の収録映像から変化分を推定してブラッシュアップしていく開発しかできなかったため、開発効率は大幅に改善した。